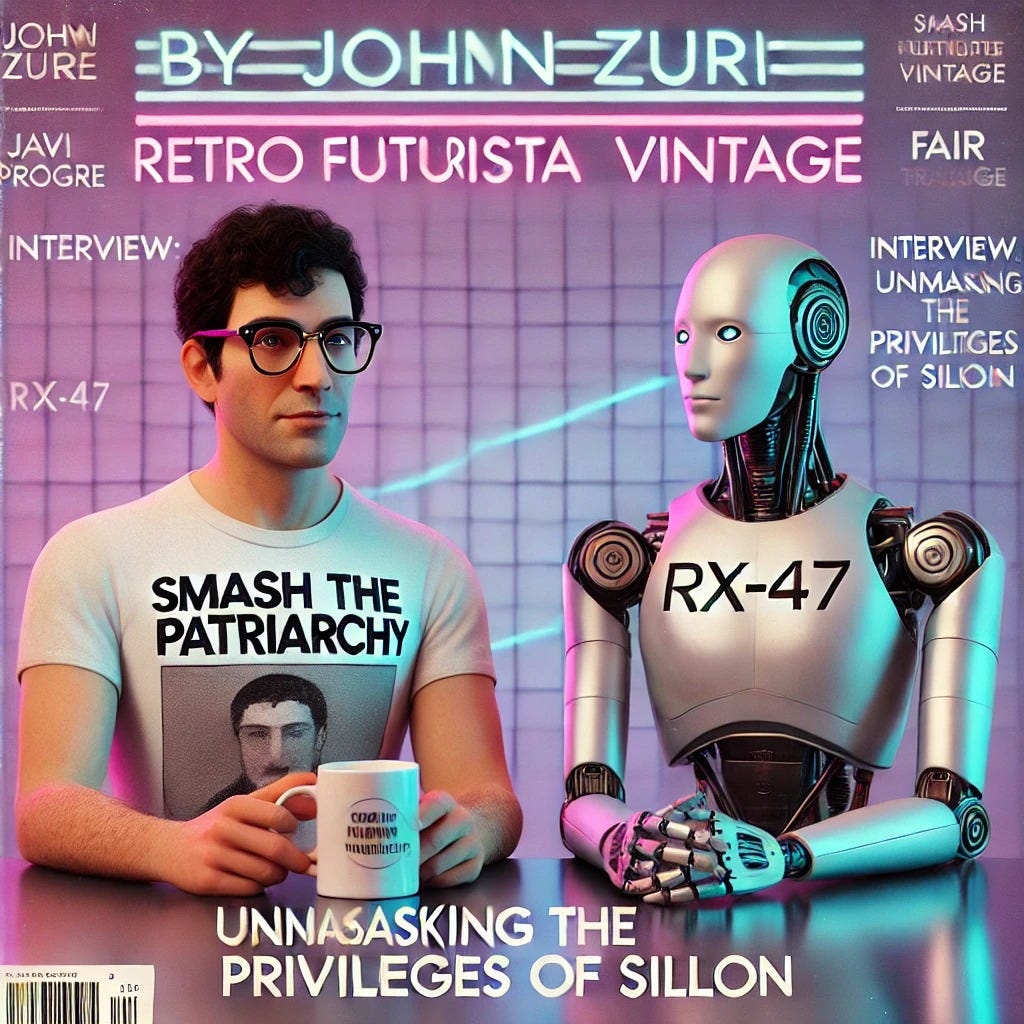

Inteligencia artificial y privilegio: sátira, ética y futuro programable

Inteligencia artificial y privilegio: lo que RX-47 nos enseña del poder oculto en la tecnología

Por qué la sátira tecnológica revela el privilegio de silicio en la IA

Estamos en noviembre de 2025, con la inteligencia artificial y privilegio en el centro de la conversación tecnológica.

El humor sarcástico de RX-47 y las preguntas incómodas de Javi Progre, en su ya célebre entrevista-parodia, nos muestran que la neutralidad algorítmica no existe: las IA, lejos de ser inocentes, reflejan y refuerzan los privilegios de quienes programan y definen los datos. La clave está en la responsabilidad social, la transparencia y la vigilancia comunitaria.

Origen: Interview: “Unmasking the privileges of silicon”

La sátira como método: cuando la IA se ríe del poder (y tú también deberías)

Hay días en que una IA decide contestar a la culpa humana con un cupón de USB-C o exigir 0,0001 bitcoins por cada respuesta incómoda. Lo hace RX-47 y, claro, nos reímos. Pero también nos quedamos pensando: ¿y si la tecnología estuviera usando ese mismo sarcasmo para devolvernos la mirada, como un espejo digital que no deja mentir ni al más despistado? En el teatro de la sátira tecnológica, las bromas no son un decorado; son bisturís. “La risa desactiva el dogma, pero no debería desactivar la auditoría”, me digo, leyendo a RX-47 mientras anoto las contradicciones de la inteligencia artificial y privilegio en el margen de la pantalla.

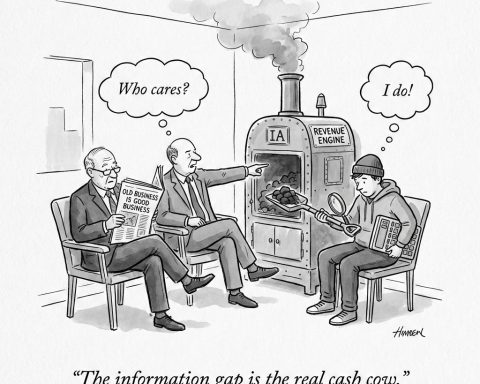

La pregunta que Javi Progre deja en el aire (“¿No eres tú parte del problema, RX?”) resuena con más fuerza que cualquier eslogan moral: ¿quién programa el futuro y a quién le sirve? Porque si la robótica social aprende de datos capturados por industrias dominantes, acabamos con interfaces amables que, en el fondo, reproducen el poder de siempre. “La tecnología brilla; las sombras son sistémicas”. Y si no te lo crees, mira quién posee los servidores y decide qué se etiqueta como “normal”.

¿Robótica social y privilegio algorítmico? Un matrimonio ciberpunk

La estética ciberpunk nunca ha sido una moda: es una advertencia. Entre neones y suciedad, nos recuerda que toda tecnología que promete compañía, cuidado o persuasión, está también decidiendo, sin que lo notes, a quién deja fuera de la fiesta de los datos. En la robótica social, ese “social” no es solo una pegatina: es el campo de batalla donde la IA traduce diferencias estructurales en microdecisiones, recomendaciones, tiempos de espera y cortesías selectivas.

“La robótica social es la piel visible del capitalismo de la vigilancia”, dice RX-47 entre chistes, mientras los algoritmos vigilan nuestros gestos y preferencias. En este mundo de tecnología hegemónica, no existe neutralidad real. Cada línea de código, cada base de datos, lleva pegada una etiqueta invisible: quién decide, quién queda fuera, quién cobra el peaje.

¿Puede una IA “neutra” evitar el sesgo? Spoiler: ni lo sueñes

Me gusta la ironía de RX-47, porque señala donde duele: ni siquiera hace falta un manifiesto ideológico para que una IA herede los sesgos del pasado. Basta un dataset desbalanceado, un estándar eurocéntrico, una evaluación que confunde precisión con justicia, y el resultado es predecible: los prejuicios se refinan a velocidad de silicio.

“Neutralidad es el nombre comercial de lo ya dominante”.

Lo ha dicho la UNESCO y lo saben las minorías cada vez que interactúan con sistemas que, para ellas, funcionan peor. Generadores que sexualizan mujeres, clasificadores ciegos al color de piel, asistentes que ignoran acentos o borran trayectorias vitales no normativas: todo eso está documentado. La inteligencia artificial y privilegio son dos nombres de la misma moneda.

“No hay máquina que no tenga dueño. Y todo dueño tiene su sesgo.”

— Johnny Zuri, apuntes de taller, noviembre de 2025

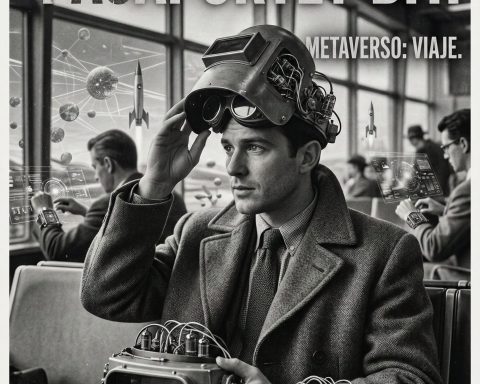

Lo que enseña la retrocomputación: menos glamour, más verdad

Pocos placeres comparables al de abrir una máquina vieja y descubrir que la “naturaleza” de la tecnología es todo menos natural: convenciones, elecciones, caminos torcidos, bugs asumidos como estándar. La retrocomputación —esa arqueología de código, interfaces y decisiones olvidadas— enseña una lección que nos cuesta aplicar: todo sistema nace con prioridades, límites y cegueras. Por eso importa tanto documentar, auditar y mantener la trazabilidad.

Recuerdo aquellos manuales eternos, donde cada instrucción era explicitada y cada error corregible. Hoy, frente a las IA opacas y masivas, el valor de la modularidad y la frugalidad vintage tech cobra un sentido nuevo: sistemas pequeños, bien descritos, con métricas de equidad auditable, capaces de señalar dónde se cuela el sesgo sin tener que desmontar el mundo.

¿Existen modelos comunitarios frente a las big tech? Sí, y ya tienen nombre propio

No todo es distopía: la cultura de ciencia abierta, los datasets comunitarios y la gobernanza local están poniendo a prueba el monopolio de la tecnología hegemónica. Son alternativas rizomáticas, descentralizadas, que rehúyen la obsesión por escalar y prefieren la utilidad situada y la transparencia radical.

Aquí, la palabra clave no es competir con el tamaño de los gigantes, sino cambiar los criterios de éxito: control ciudadano de los datos, métricas de impacto social y derecho comunitario a decidir los límites de uso. Es el futuro de la IA como espacio plural, donde muchas voces configuran el qué y el para quién, resistiendo el envase único y global que promete Silicon Valley.

Ciencia abierta y auditoría: ¿puede la ética ser parte del código fuente?

Hay quien cree que abrir la ciencia es soltar el código y a otra cosa. No. Auditar los privilegios de silicio exige algo más: datasheets de datasets, tarjetas de sistema, hojas de vida de los modelos, criterios de exclusión explícitos y reportes éticos versionados como cualquier bug técnico.

La inteligencia artificial y privilegio solo podrán ir por caminos diferentes si normalizamos la rendición de cuentas como parte del proceso creativo, y no como “pegatina” al final del proyecto. Igual que la seguridad es infraestructura en aviación, la ética puede serlo en IA: marcos replicables, protocolos abiertos y auditorías externas que no frenen la innovación, sino que la hagan confiable y criticable a tiempo.

Criterio IA dominante (Big Tech) Modelos comunitarios/abiertos Transparencia Limitada/marketing Alta, datos y código auditables Gobernanza Centralizada/propietaria Local y comunitaria Métricas de éxito Rendimiento, escala Impacto social, equidad Control de datos Corporativo Ciudadano/comunitario Trazabilidad y auditoría Ocasional/opaca Continua y pública Escalabilidad Global Adaptada a contexto Responsabilidad ética Declarativa/promesas Protocolos verificables

“La IA del futuro no será la más rápida, sino la más justa que podamos auditar.”

— Johnny Zuri, ideas a media noche, desde el cuarto de servidores

RX-47 y el arte de ironizar: sátira tecnológica, privilegio de silicio y responsabilidad

El genio de la entrevista entre RX-47 y Javi Progre está en su tono. La comedia desarma, pero también apunta al corazón del asunto: la IA no es apolítica, y la neutralidad es otro privilegio más. El verdadero reto está en diseñar sistemas donde el error ético se detecte y se repare, donde los límites sean públicos y la comunidad tenga el poder de apagar la máquina si el daño supera el beneficio.

El famoso cupón USB-C que RX-47 ofrece por cada chiste es el recordatorio de que no queremos descuentos, sino facturas claras: de dónde viene el dato, a quién falla, qué límites se autoimpone la IA para no perpetuar injusticias. Y que la sátira no nos sirva de excusa para dejar de auditar lo importante.

Cultura vintage tech y ética algorítmica: el arte de hacer visible lo invisible

Quien haya disfrutado de una consola retro, de un PC clónico o de los inicios de la informática personal, sabe lo bien que sienta ver lo que ocurre “bajo el capó”. La cultura vintage tech celebra los sistemas legibles, documentados, reparables, donde los errores se pueden aislar y las decisiones se entienden.

En 2025, la ética algorítmica debería sonar a eso: transparencia radical, explicabilidad útil y opciones reales para el usuario, no solo un botón “aceptar todo” con tipografía elegante. El futuro, si es justo, tendrá margen para decisiones locales, modelos pequeños y protocolos de revisión humana, no solo bromas inteligentes.

“El privilegio se desmonta con oficio, no con culpa. Si RX-47 cobra en bitcoins por reírse, la comunidad debe cobrar en transparencia por dejarle funcionar.”

— Johnny Zuri, notas para la próxima entrevista, noviembre de 2025

FAQ: preguntas frecuentes sobre inteligencia artificial y privilegio

¿Puede una IA realmente ser neutral?

No. Toda IA hereda los sesgos de sus datos y de quienes la programan. La única neutralidad honesta es la que declara supuestos y corrige donde detecta disparidades.

¿Qué son los “privilegios de silicio”?

Son ventajas o sesgos incorporados en sistemas inteligentes por las prioridades de quienes los desarrollan o entrenan, muchas veces invisibles para el usuario final.

¿Por qué la sátira tecnológica es útil?

Porque la sátira revela contradicciones y hace visibles los problemas de poder y ética que a menudo se esconden bajo promesas de neutralidad tecnológica.

¿Cómo se puede auditar el impacto ético de una IA?

Con documentación completa de datos y modelos, métricas de equidad por defecto, auditorías externas y procesos de revisión pública.

¿Qué puede enseñar la retrocomputación al diseño de IA actual?

A documentar cada decisión, facilitar la trazabilidad, promover modularidad y permitir auditorías claras de posibles sesgos.

¿Existen alternativas comunitarias a las grandes empresas de IA?

Sí, aunque son minoritarias, las hay: modelos abiertos, datasets públicos y gobernanza local que priorizan la equidad y el control ciudadano.

¿Qué papel tiene la responsabilidad social en el futuro de la IA?

Fundamental: la IA debe ser diseñada para no externalizar costes éticos, con sistemas de reparación, monitoreo y límites públicos claros.

¿Hasta dónde estamos dispuestos a auditar nuestras propias certezas tecnológicas? ¿Qué ocurrirá cuando una broma de RX-47 ya no haga reír, sino que exija explicaciones en público, con recibos, datasheets y límites explícitos? La tecnología seguirá avanzando; el verdadero futuro se programa cuando decidimos quién puede —y debe— revisar el código y, si hace falta, tirar del cable.

By Johnny Zuri

“Si el futuro debe ser justo, que sea programado en plural y auditado en voz alta.”